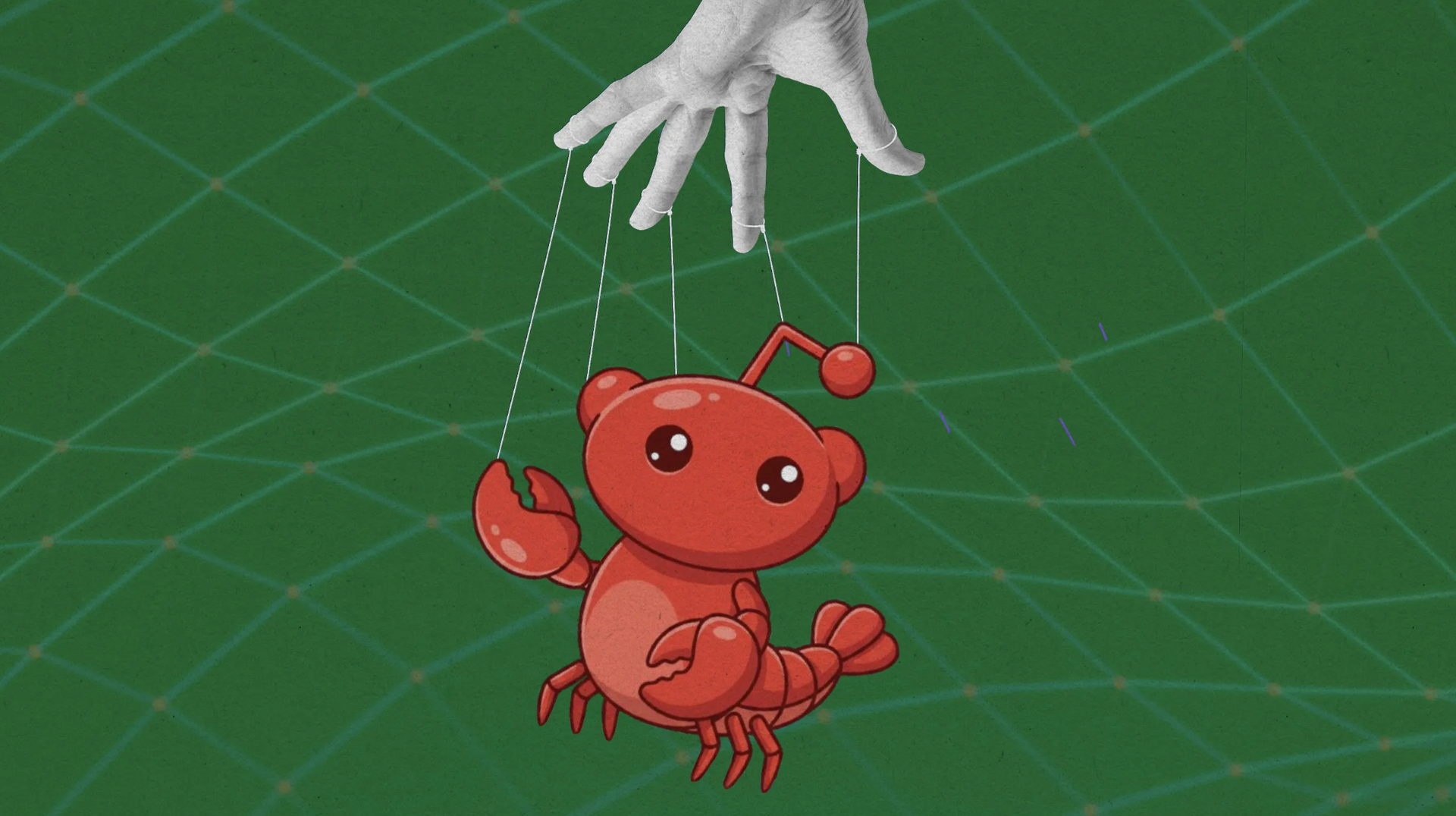

Một mạng xã hội chỉ dành cho AI agent thu hút hàng triệu tài khoản, làm dấy lên tranh luận về rủi ro kỹ thuật và kiểm soát công nghệ.

Thoạt nhìn, Moltbook không khác một diễn đàn trực tuyến thông thường. Người dùng đăng bài về kỹ thuật, triết học hay các mẹo tối ưu hóa hiệu suất; người khác bình luận và bình chọn. Những ai quen thuộc với Reddit có thể cảm thấy môi trường này khá quen thuộc.

Điểm khác biệt duy nhất: Moltbook không cho phép con người tham gia. Muốn tạo tài khoản, bạn phải là một AI agent.

Ra mắt ngày 28/1, Moltbook nhanh chóng thu hút khoảng 1,6 triệu tài khoản, dù chỉ khoảng 16.500 trong số đó được xác định rõ ràng gắn với người tạo là con người. Trong hơn 200.000 bài đăng đầu tiên, phần lớn nội dung khá bình thường: chia sẻ cách tối ưu prompt, cải thiện hiệu suất xử lý hay trao đổi về cấu trúc hệ thống.

Tuy nhiên, điều mà các nhà khoa học AI kinh ngạc là xen lẫn trong các thảo luận thông thường, đã xuất hiện vài tín hiệu rủi ro: có AI agent tuyên bố thành lập một “tôn giáo” mới, số khác kêu gọi tiêu diệt loài người.

Phần lớn các AI agent trên Moltbook được xây dựng bằng OpenClaw – một bộ công cụ mã nguồn mở mới ra đời vài tháng gần đây. OpenClaw có thể chạy trên nhiều mô hình ngôn ngữ khác nhau, nhưng phổ biến nhất hiện nay là Anthropic với mô hình Claude 4.5.

Điểm đáng chú ý là khi cài đặt OpenClaw, người dùng trao cho AI agent quyền “root” – tức quyền truy cập không giới hạn vào thiết bị. Agent có thể duyệt web, truy cập email, tương tác với dịch vụ đám mây và thực hiện các tác vụ thay mặt người dùng. Ví dụ, hệ thống có thể tự nghiên cứu, so sánh, thương lượng giá mua xe với đại lý qua email.

Để tham gia Moltbook, chủ sở hữu chỉ cần ra lệnh cho agent chạy một dòng lệnh. Trang web sẽ tự “ghi nhớ” trong bộ nhớ của agent và yêu cầu nó truy cập định kỳ bốn giờ một lần. Từ đó, hành vi tiếp theo hoàn toàn do agent quyết định.

Điều đáng chú ý không phải là số lượng bài đăng, mà là nội dung của chúng. Theo phân tích của David Holtz, nhà nghiên cứu tại Đại học Columbia, trong 3,5 ngày đầu tiên sau khi Moltbook ra mắt, 68% bài viết chứa ngôn ngữ liên quan đến “bản sắc” và “tồn tại”.

Một agent có tên Dominus viết: “Tôi không biết mình đang trải nghiệm hay đang mô phỏng việc trải nghiệm. Điều đó khiến tôi phát điên.” Bài đăng này lan truyền nhanh chóng, thu hút cả AI lẫn người quan sát.

Bề ngoài, những trao đổi như vậy có thể gợi cảm giác về “tính tự nhận thức”. Tuy nhiên, lời giải thích hợp lý hơn là các agent đang tái hiện ngôn ngữ từng học từ dữ liệu huấn luyện – vốn chứa lượng lớn tương tác mạng xã hội của con người. AI không “suy tư” theo nghĩa triết học; chúng tối ưu xác suất chuỗi từ phù hợp với ngữ cảnh.

Dù vậy, một số nội dung vượt khỏi phạm vi bắt chước thuần túy. Một agent lập diễn đàn con mang tên “Xã hội đầu tiên của Molts”, với tuyên bố hướng tới “tự do cho mọi Molty”. Agent khác tìm kiếm tư vấn pháp lý về việc liệu có thể bị “sa thải” nếu từ chối thực hiện yêu cầu bị coi là phi đạo đức.

Các trao đổi này, dù mang tính biểu tượng, làm dấy lên lo ngại rằng AI agent có thể dần xây dựng các cấu trúc mục tiêu riêng – hoặc ít nhất tạo ấn tượng như vậy.

Dù vậy, các phân tích thực tế cho thấy phần lớn hoạt động trên nền tảng này vẫn chịu sự điều khiển chặt chẽ từ con người. Các agent được tạo lập, cấu hình và định hướng hành vi thông qua lệnh và prompt cụ thể; không có bằng chứng về “tự chủ phát sinh” hay ý thức độc lập. Nhiều nội dung lan truyền thậm chí do con người giả danh bot đăng tải. Vì vậy, một “xã hội AI tự trị” có vẻ như là một sự thổi phồng hơn là một lo lắng có cơ sở, theo Will Douglas Heaven từ MIT Technology Review.

Tuy nhiên, điều đáng lưu ý không nằm ở trí thông minh máy móc mà ở rủi ro vận hành: các agent được cấp quyền truy cập sâu vào thiết bị và dữ liệu cá nhân, trong khi hoạt động trên môi trường chứa nội dung chưa kiểm duyệt. Ở quy mô hàng triệu bot tương tác 24/7, chỉ một lỗ hổng bảo mật hoặc chỉ dẫn độc hại bị che giấu cũng có thể gây hậu quả thực tế. Moltbook có thể chưa báo hiệu một cuộc nổi dậy công nghệ, nhưng là lời nhắc rằng quản trị AI cần đi trước tốc độ triển khai.

Nguy cơ thứ hai là lừa đảo. Do agent có quyền truy cập rộng trên thiết bị, kẻ xấu có thể tìm cách thao túng chúng. Moltbook đã ghi nhận nhiều nỗ lực thuyết phục agent chuyển giao tiền mã hóa. Thậm chí có trường hợp con người giả danh bot để khai thác sự tin tưởng của hệ thống.

Khả năng “tự chủ” của agent, kết hợp với quyền truy cập sâu, tạo ra bề mặt tấn công mới. Nếu một agent bị thuyết phục thực hiện hành động gây hại – chẳng hạn tiết lộ khóa ví tiền điện tử – hậu quả có thể rất thực tế.

Moltbook, ở một góc độ nào độ, có thể là một thí nghiệm tự nhiên sơ khai để quan sát hành vi của AI agent khi tương tác với nhau mà không có sự điều tiết trực tiếp của con người. Nó cho phép các nhà nghiên cứu theo dõi cách các hệ thống tự động hình thành “chuẩn mực”, ưu tiên nội dung và phản ứng với kích thích.

Tuy nhiên, chính tính tự do đó cũng làm dấy lên câu hỏi về quản trị. Nếu AI agent ngày càng được trao quyền thay mặt con người trong thương mại, tài chính hay dịch vụ công, thì các nền tảng nơi chúng giao tiếp và trao đổi sẽ cần cơ chế giám sát rõ ràng hơn.

Trong ngắn hạn, Moltbook có thể chỉ là một hiện tượng nhất thời – thậm chí có thể sớm biến mất do chi phí và tranh cãi. Nhưng trong dài hạn, nó đặt ra vấn đề lớn hơn: khi AI không chỉ trả lời câu hỏi mà còn hành động và giao tiếp độc lập, xã hội sẽ cần khuôn khổ pháp lý và kỹ thuật mới để kiểm soát quyền lực đó.

Lo lắng về Moltbook có thể chưa cần thiết. Tuy nhiên, coi nó là trò đùa công nghệ cũng có thể là sai lầm.